HDFS分布式文件系统和ZooKeeper

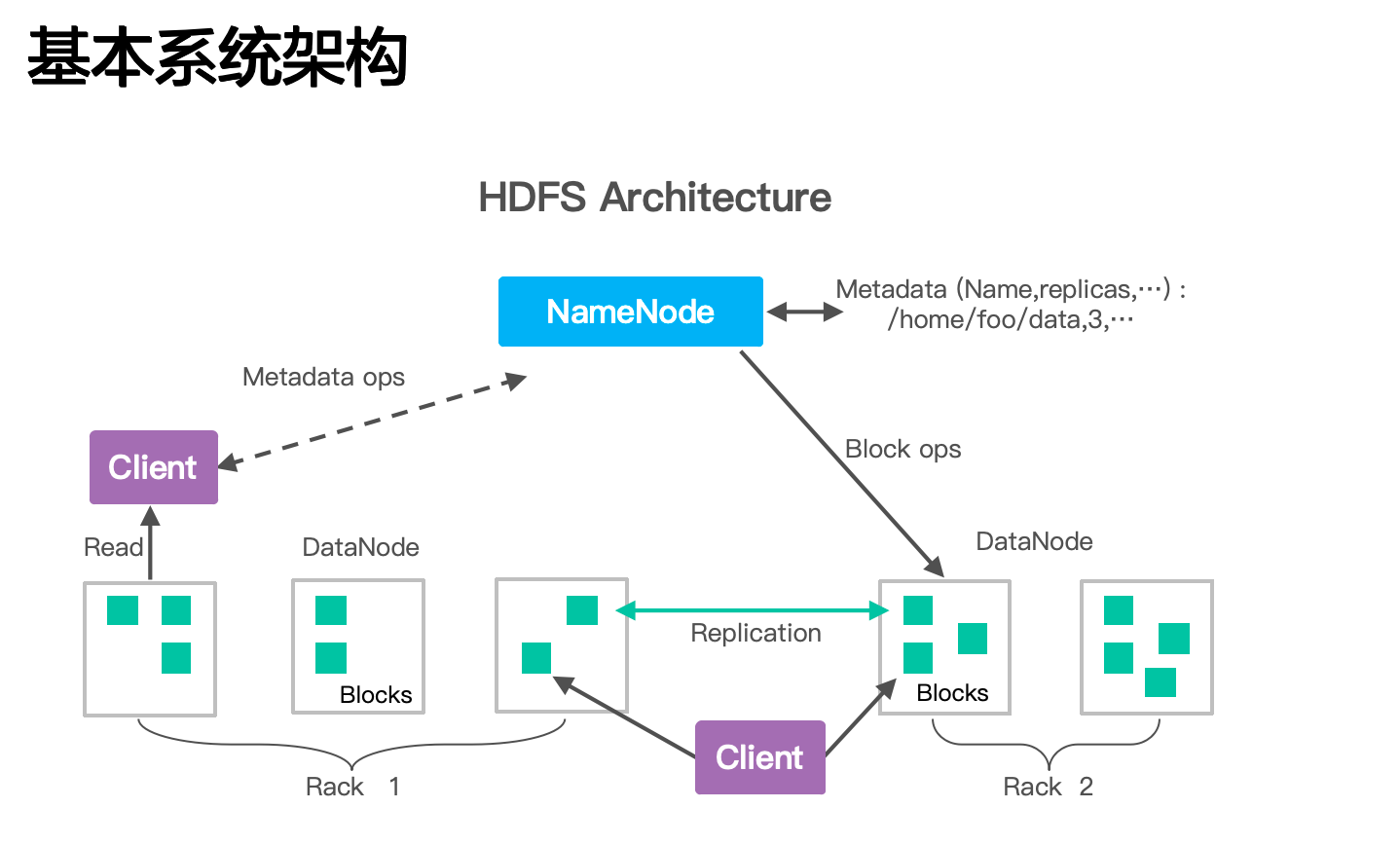

Hadoop分布式文件系统(HDFS)是一种旨在在商品硬件上运行的分布式文件系统。

HDFS具有高度的容错能力,旨在部署在低成本硬件上。

HDFS提供对应用程序数据的高吞吐量访问,并且适用于具有大数据集的应用程序

HDFS放宽了一些POSIX要求,以实现对文件系统数据的流式访问。

HDFS最初是作为Apache Nutch Web搜索引擎项目的基础结构而构建的。

HDFS是Apache Hadoop Core项目的一部分。

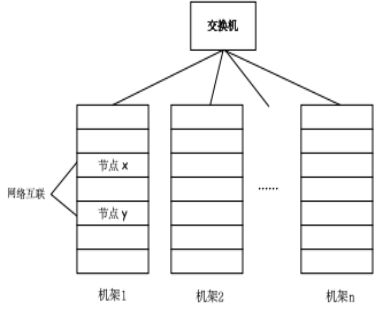

分布式文件系统把文件分布存储到多个计算机节点上,成千上万的计算机节点构成计算机集群。

目前的分布式文件系统所采用的计算机集群都是由普通硬件构成的,这就大大降低了硬件上的开销。

HDFS默认一个块128MB,一个文件被分成多个块,以块作为存储单位。

块的大小远远大于普通文件系统,可以最小化寻址开销。

抽象的块概念可以带来以下几个明显的好处:

支持大规模文件存储

简化系统设计

适合数据备份

第02章 HDFS分布式文件系统和ZooKeeper.pptx

培训视频1 hdfs链接: https://pan.baidu.com/s/1ChBvX-N1FnNGSHV4kPzkyg 提取码: xb45

培训视频2 hdfs链接: https://pan.baidu.com/s/1ggVgEkJRDgckO1GlCF5ZqQ 提取码: bp5d

培训视频3 ZooKeeper链接: https://pan.baidu.com/s/1Acdx-8QO8Bnkgah0qLCijg 提取码: ww2w